Die Glückwünsche der stellvertretenden ND-Leiterin zum 40jährigen Jubiläum

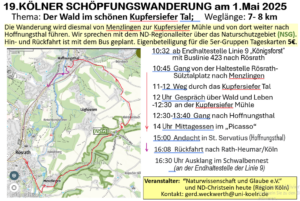

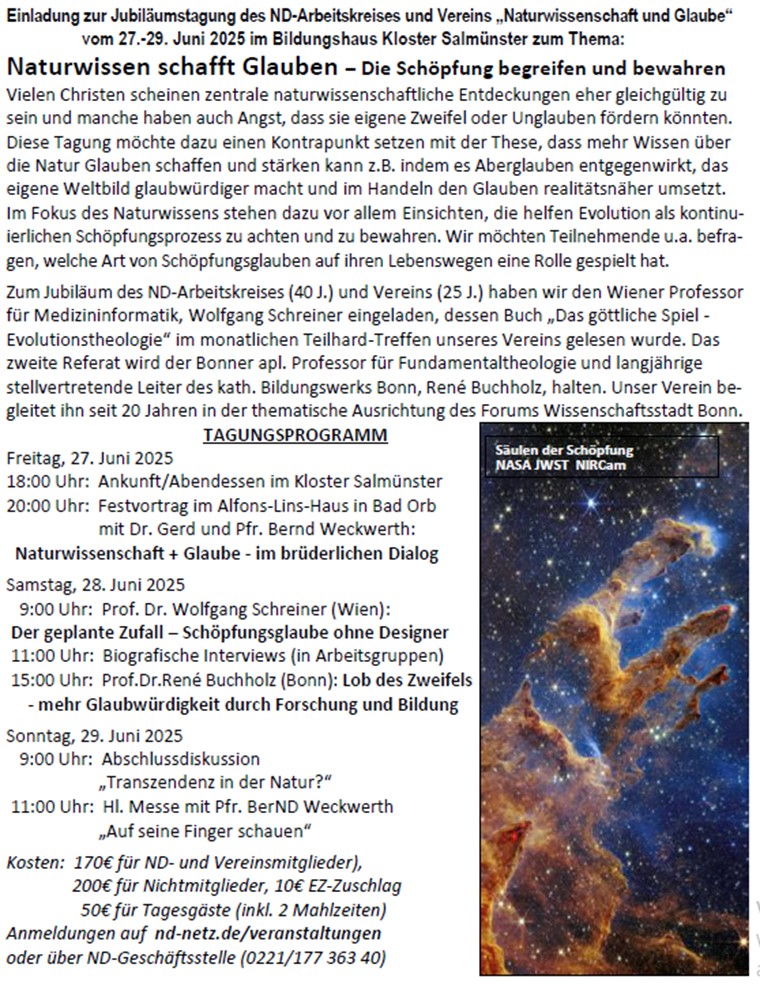

Zur Feier von 40 Jahre Arbeitskreis und 25 Jahre Verein „Naturwissenschaft und Glaube“ hatte das aktuelle Leitungsteam bestehend aus Barbara Rempe, Kurt Schanné, Bernd und Gerd Weckwerth am Eröffnungsabend der diesjährigen Tagung (27.-29. Juni im Kloster Salmünster) zu einen öffentlichen Vortrag im benachbarten Bad Orb eingeladen, zu dem ~65 Personen ins dortige Alfons-Lins-Haus gekommen waren.

„Naturwissenschaft und Glaube im brüderlichen Dialog“

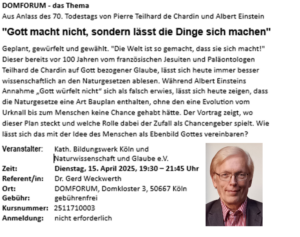

Unter diesem Thema gaben die Initiatoren des AKs vor 40 Jahren, die Zwillingsbrüder Pfr. Bernd und Dr. Gerd Weckwerth nicht nur einen Rückblick, sondern zeigten aus ihrer persönlichen und beruflichen Sicht, wie dieser Dialog heute gelingen kann. Nach einer kurzen Vorstellung der unterschiedlichen Themen, mit denen sich der AK in 40 Jahren beschäftigt hat, begann Gerd Weckwerth mit einer von Chat GPT übernommenen Definition und Verhältnisbeschreibung von Naturwissenschaft und Glaube. Diese sei heute immer schwerer, da sich Zuständigkeiten teils verschieben und überlappen. Abwegig werde es z.B., wenn man religiösen Glauben in einer Art Rückzugsgefecht, nur noch für Inhalte erwäge, die von der Wissenschaft noch nicht erklärt seien. Der Anspruch des Glaubens müsse sein, dass gerade wissenschaftliche Erkenntnisse uns den Wundern der Schöpfung näher bringen können.

Ausgehend vom 1. Schöpfungsbericht, der eher dazu gedient habe, eine 7-Tage-Woche zu etablieren, meinte Pfr. Weckwerth darin auch schon eine erste prophetische Schau einer kosmischen Entwicklung zu sehen. An allen 6 Tagen erschaffe Gott etwas Neues, ohne selbst in Erscheinung zu treten. Durch sein Wort mache Gott aber, dass es sich macht.

Mit der Urknalltheorie, glaubte sein in Physik und Kosmochemie promovierter Bruder, habe sich das frühere statische Weltbild im 20. Jahrhundert dynamisiert. Auch der Schöpfungsglaube lasse sich damit über die biologische Evolution hinaus, im Rahmen einer universellen Evolution neu ausrichten. Zu den am Anfang allein geltenden Naturgesetzen der Physik, mussten über Milliarden von Jahren erst chemische Elemente, Planeten, Leben, Menschen und Kulturen hinzukommen, um heute Religion und Wissenschaft zu ermöglichen.

Die genauen Abläufe der Übergänge zu den dabei neu auftauchenden Wissenschaftsfeldern (Chemie, Geo-, Bio-, Human- und Geisteswissenschaften) sind Gegenstand aktueller Forschung und waren im Fall des Lebens und des Menschen auch Thema von AK-Tagungen. Alle diese Übergänge offenbaren darüber hinaus das im Anfang vorhandene Potential zur universellen Evolution, das nur bei äußerst fein aufeinander abgestimmten Naturgesetzen und spezifischen Bedingungen denkbar sei. Womöglich könne die universelle Evolution in dieser Abfolge sogar der einzige Weg zu freien, selbstverantwortlichen Individuen gewesen sein.

Im Rahmen eines „Schöpfungstages“ will sein Bruder eine solche zeitgemäße Gesamtschau schon Schülern der Mittelstufe nahebringen und den Einfluss auf deren Welt- und Gottesbild untersuchen. Dazu sollen die Lehrer der Fächer Physik, Chemie, Erdkunde, Biologie, Religion und Geschichte nacheinander ihr Unterrichtsfach selbst zum Thema machen, wann und wie es relevant wurde im Kosmos und für unser personales Bewusstsein. Dem Religionslehrer käme es zu, die Menschwerdung zum homo religiosus zu behandeln und was uns Menschen vom Tier unterscheide bzw. als Person mit Gott verbinde.

Diese personale Perspektive, sei Dreh- und Angelpunkt aller Theologie, meinte der Pfarrer, eine zentrale subjektive Erfahrung, auch wenn sie die objektive Wissenschaft eher störe. Gerade bei Fragen, nach Gut und Böse, wie sinn- und wertvoll etwas sei, nach Freiheit und Verantwortung und einem Leben nach dem Tod käme diese menschlichste Seite unserer Existenz besonders zum Tragen. Das tauche die Welt der Fakten aber in ein neues Licht.

Doch in allen Fragen der Außenwelt, meinte Pfr. Weckwerth, sei er durch und durch Naturwissenschaftler geblieben. Hier gehe alles mit rechten Dingen zu! Da habe Gott eine höchstverlässliche Basis geschaffen, gegen die es abwegig sei, zusätzliche göttliche Eingriffe zu erwarten. Mancher Aberglaube lebe jedoch auch in der Kirche weiter und verführe viele, Absonderliches von Gott zu glauben und zu erhoffen. Da sei es besser, Naturwissen zu erwerben und auf diese Weise staunend den Schöpfer in allem wahr zu nehmen, was er im Rahmen der Evolution habe entstehen lassen. Das oft geringe Interesse der Theologen an den Wundern der Schöpfung sei dagegen entlarvend. „Ein Maler wäre doch auch verstört, wenn man ihn dauernd als großen Maler ehre, aber an seinen Kunstwerken kaum Interesse zeige“.

Auch als Basis des Glaubens sei ein realistisches Weltbild hilfreich, so wie es Jesus von Nazareth vorlebte, der die unangenehmen Seiten der Realität wie Leid, Schuld und Tod sogar konsequent auf sich nahm und durch Erlösung, Vergebung und Auferstehung Wege zu deren Überwindung anbot. Selbst unsere innersten Denkstrukturen seien durch äußere Sinneswahrnehmungen beeinflusst, meinte Pfr. Weckwerth. In Sprüchen wie „Man sieht nur mit dem Herzen gut“ (aus Exupérys „Der kleine Prinz“), zeige sich eine Art inneres Sehen, das sich äußerer Wahrnehmung entziehe. Es könne aber die äußere Sicht der Naturwissenschaft gut ergänzen, was aber viel zu selten geschehe.

So schlugen die Brüder am Ende vor, eine höhere Perspektive einzunehmen (eine gleichsam göttliche Sicht) um in einem Overview-Effekt beide Positionen gemeinsam wahrzunehmen: „Daher habe der AK in 40 Jahren viele Fragen ganzheitlicher sehen und bewerten können!“ In diesem Sinne könne der im AK-Gründungsjahr 1985 von Julie Gold geschriebene Text des spätere Welthits „From a distance“ zum Dialog von Naturwissenschaft und Glaube ähnlich wie der ganzheitliche Blick auf die Erde aus dem Space Shuttle außerordentlich anregen.

„Der geplante Zufall – Schöpfungsglaube ohne Designer“

Am Samstagmorgen stellte zunächst Prof. Dr. Wolfgang Schreiner, Medizininformatiker an der Universität Wien, eine Auswahl von Thesen aus seinem 2013 erschienenen Buch „Das göttliche Spiel“ vor. Auch er begann mit den Schöpfungsberichten der Genesis, die beide nahelegen, dass Gott alle Lebewesen und den Menschen zielgerichtet und gut erschaffen habe. Spätestens mit Darwin sei aber eine zufällige Evolution ins Spiel gekommen, die später von Teilhard de Chardin als Schöpfungswerkzeug Gottes gedeutet wurde. Daraus habe sich ein bis heute dauernder Streit entwickelt, ob dieses zielgerichtet oder zufällig verlaufen sei.

An eindrucksvollen Beispielen zeigte Schreiner den molekularbiologische Informationsfluss von der DNA über die RNA bis hin zu den Aminosäuren und Proteinen. Er führe alleine schon auf Grund der immensen Menge der in jedem Moment übertragenen Daten zwangsläufig zu „Ablesefehlern“. Die dadurch ausgelösten Mutationen könnten sich in der Abfolge der Generationen einer Art entweder durchsetzen oder würden aufgrund geringerer Fortpflanzungsraten ausselektiert. Dieser Prozess halte die Evolution des Lebendigen in Gang und spiele sich bis heute ab. Jeder Mechanismus, der manchmal zu neuen Arten führe, bringe für das betroffene Lebewesen aber weit häufiger Krankheit und Tod.

Auch im menschlichen Erbgut treten immer wieder Mutationen auf, z.B. bei der Immunabwehr oder bei der Bildung von Resistenzen. Es scheine, als ob Gott sich im Zufall „verstecke“ und – ähnlich einem Lotteriespiel – das Gute durch Zufall „bewirke“. Sobald er auf den Plan komme, entstehe jedoch die Theodizee-Frage. Wie könne ein „liebender Vater“ sich so grausamer (erscheinender) Mechanismen „bedienen“?

Schreiner antwortete darauf nicht direkt, sondern mit Hinweis auf die jesuanische Ethik und das Handeln Jesu. Die Botschaft der Bergpredigt etwa wirke gezielt den evolutionären Mechanismen und ihrer Selektion der Schwächeren entgegen. Sie ist gegen die „Kollateralschäden“ gerichtet. Jesus setze sich am Ende selbst der Bosheit, der Gewalt und dem Tod aus und werde darin mit uns solidarisch. Auf diese Weise ereignet sich „Erlösung von dem Bösen“. So könne man schließlich in der Härte des „Bios“ doch einen „Logos“, einen Sinn erkennen.

Schreiner endete mit dem Beispiel der Genschere, die er als ein mögliches Schöpfungswerkzeug in Menschenhand bezeichnete. Wäre Gott ein Designer, hätte er so oder ähnlich arbeiten können, um zielgerichtet erschaffen zu können. Stattdessen habe er uns Menschen solche Werkzeuge in die Hand gelegt, uns von Erblasten selbst zu erlösen, bzw. sie gesellschaftlich gezielt einzusetzen. Doch welche Typen werden Hohepriester und bestimmen die Ziele?

Biografische Gesprächskreise

Zu den drei themengleichen Workshops waren Fragen zum persönlichen Einschätzung von Naturwissenschaft und Glaube vorbereitet worden, mit denen sich zunächst jeder für sich beschäftigen sollte, bevor sich ein Gespräche über die ausgewählte Antworten anschloss. Eine Auswertung der ausgefüllten Fragebogen zeigte, dass sich über die Hälfte der Teilnehmer schon in der Schulzeit mit ähnlichen Grenzfragen beschäftigt hat. Als die heute interessantesten Themen wurden medizinethische und naturschutzbezogene Fragen favorisiert.

Als spannendste Tagung wurde am häufigsten die von 2019 zum Thema „Anthropozän“ mit E.U. Weizsäcker“ ausgewählt. Daneben gaben Andere auch 14 weitere Tagungen bzw. deren Themen als die jeweils spannendsten an, was die Breite der thematischen Interessen widerspiegelt. Höchste Zustimmung fand die Aussage, dass Wissen über die Natur einen vernünftigen Glauben fördert und Aberglauben bekämpft.

„Lob des Zweifels – mehr Glaubwürdigkeit durch Forschung und Bildung“

In seinem nachmittäglichen Vortrag erläuterte Dr. René Buchholz, außerordentlicher Professor für Fundamentaltheologie der Universität Bonn, dass das vormoderne geschlossene Weltbild nicht nur durch die Naturwissenschaften (Galilei, Darwin, Freud), sondern parallel hierzu auch durch die sich emanzipierenden Geisteswissenschaften, namentlich die Philosophie, die Geschichtswissenschaften und die Sprachwissenschaften, einer Revision unterzogen wurde. Diese stellen den Menschen und seine Vernunft in den Mittelpunkt, zeigen zugleich aber auch die Grenzen seiner Erkenntnismöglichkeiten und seiner Freiheit auf. Die Religion wird zu Gunsten der säkularen Welt in ihrem alles bestimmenden Einfluss zurückgedrängt. Sie ist in der modernen, zunehmend pluralen Gesellschaft ein gesellschaftliches Subsystem unter anderen und vornehmlich für „Kontingenzbewältigung“ zuständig.

Die in der Neuzeit aufkommende historisch-kritische Bibelwissenschaft (Spinoza, Reimarus, Strauss) erkennt, auch unter dem Einfluss der aufkommenden Naturwissenschaften, den narrativen Charakter der biblischen Texte und verabschiedet damit die vorher erhobenen Wahrheitsansprüche. Die heute selbstverständliche Unterscheidung zwischen Aussageabsicht und Aussageform der biblischen Texte wird erstmals systematisch angewendet. Die „Entzauberung“ der biblischen Texte ist die logische Folge. Diese Betrachtungsweise führte allerdings bei nicht wenigen Aufklärern zu einer erheblichen Umdeutung, wenn nicht gar zur Verabschiedung der traditionellen Religion bzw. jeder Religion.

Im 20. Jahrhundert wurde dann mehrfach der Versuch unternommen, den christlichen Glauben mit der modernen Wissenschaft, vor allem der Evolutionstheorie zu „versöhnen“. Besonders ist hier Teilhard de Chardin zu nennen. Sein „kosmischer Christus“ hat jedoch keine Gemeinsamkeit mehr mit dem Verkünder der Gottesherrschaft aus Galiläa. Die Evolution kennt kein Erbarmen. Sie ist gegenüber ethischen Standards und dem Schicksal des Einzelnen indifferent. Dieser Hiatus beschäftigte schon den Meisterdenker Immanuel Kant.

Zwar hielt er die Lehren der christlichen Dogmatik für entbehrlich, aber die Existenz Gottes war für ihn ein Postulat der praktischen Vernunft. Nur Gott kann den Ineinsfall von Moralität und Glückseligkeit garantieren. Einfacher gesagt: Nur unter der Voraussetzung seiner Existenz kann konsistent gedacht werden, dass der moralisch gute Mensch am Ende auch der glückliche Mensch ist. Der gute Mensch darf trotz des evolutionär programmierten Leidens bis hin zum Tod mit Gründen auf die ewige Seligkeit hoffen.

„Schauen auf die Finger Gottes“

Nach einem unterhaltsamen Abend im Brunnenhof des Klosters, begleitet vor allem durch Akkordeon-Musik von Pfr. Bernd Weckwerth, ging es am Sonntagmorgen zunächst um neue und aktuelle Themenbereiche für zukünftige Tagungen. Dabei wurden Themen wie Transzendenz in der Natur, Wahrheit und Fake-News, Aktuelles zum Klimawandel, sowie Psychologie des Glaubens angesprochen. Unter welcher Ausrichtung und mit welchen Referenten wir uns für eines dieser Themen entscheiden, hängt u.a. davon ab, welche Vorschläge und Angebote uns jeweils vorliegen. Daher freut sich das Leitungsteam über jede Idee und Infos zu diesen Themen. Fest stehen für die nächsten zwei Jahre nur die Termine, die im Kloster Salmünster gebucht sind (2026: 21.-23.8.; 2027: 20.-22.8.).

Schon als Schüler habe er jede Beschäftigung mit Naturwissenschaften im übertragenen Sinne als „Schauen auf die Finger Gottes“ gedeutet, meinte Pfr. Bernd Weckwerth als Zelebrant des abschließenden Gottesdienstes. Auch das Tagungsthema: „Naturwissen schafft Glauben“, sei von dieser Auffassung her, eine ganz natürliche Folge bei der Gewinnung objektiver Fakten. Die Forderung nach Bewahrung der Schöpfung beschütze nicht nur alle Geschöpfe – auch uns -, sondern mache uns selbst zur Stütze und zu Säulen der Schöpfung.

Gerd und Bernd Weckwerth sowie Kurt Schanné